基于RTVC-7 Voice Cloning Model 的Tuned-GE2E-SayEN-EarSpeech 搭建怎样的

基于RTVC-7 Voice Cloning Model 的Tuned-GE2E-SayEN-EarSpeech 搭建怎样的,相信很多没有经验的人对此束手无策,为此本文总结了问题出现的原因和解决方法,通过这篇文章希望你能解决这个问题。

0. 说明

和 https://blog.csdn.net/u013625492/article/details/114433738 中 GE2E 的版本几乎一致

区别就是文本是 英文, 使用 VCTK 等英文数据集训练

1. Git Clone

https://github.com/ruclion/Tuned-GE2E-SayEN-EarSpeech

2. 训练数据

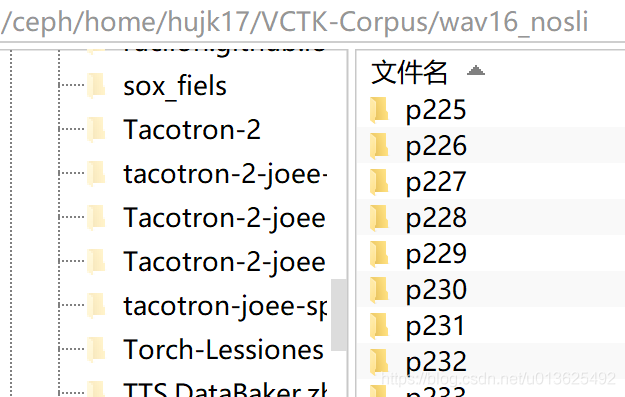

2.1. VCTK

之前训练 AutoVC 用过

处理数据的逻辑从: /ceph/home/hujk17/Tuned-GE2E-SayEN-EarSpeech/FaPig_extract_GE2E_VCTK_nosli.py 开始

保留了 train, val, unseen. 训练的时候只使用 train

3. speaker embedding

在 2.1. 中也一并提取了, 使用 GE2E

4. 预处理数据 -> mel

在 2.1. 中也一并提取了, 使用 实验室的 mel. 嘿嘿(●ˇ∀ˇ●), 终于方便啦

5. 改代码

symbols 不用动, 本身就保留了英文的标点

需要改下 train.txt 的路径

以 Kiss 为模型名字, 逻辑从 Kiss_train.py 开始

直接用 本来的小 Batch 训练, batch_size = 12

6. GE2E 版逻辑

256 的 Embedding 仍然后面接了一个 FC, 和中文的一致

中文的叫 FaPig, 英文叫 Kiss, 逻辑从 Kiss_train.py 开始

from synthesizer.FaPig_train import train 和 from synthesizer.Kiss_train import train 其实完全一致, 只是为了统一格式, 拷贝了一份

看完上述内容,你们掌握基于RTVC-7 Voice Cloning Model 的Tuned-GE2E-SayEN-EarSpeech 搭建怎样的的方法了吗?如果还想学到更多技能或想了解更多相关内容,欢迎关注蜗牛博客行业资讯频道,感谢各位的阅读!

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:niceseo99@gmail.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。

评论